「システム86」から「システムI」、回転拡大縮小機能を標準搭載した「システムII」へ。どんどん豪華になるアーケードゲームの演出はシステム基板のサウンドIC構成にも大きな影響を与えていきました。第2章前編ではFM(シンセサイザー)音源とともにナムコ独自のPCM(サンプリング)音源「C140」や「C352」がどういう経緯で開発されたのかを掘り下げていきましたが、今回の中編ではFM音源の話題を中心にサウンドクリエイターの方々にお話を伺っていきます。

小川 徹

細江 慎治

1985年、ナムコ(当時)のテストプレイにアルバイトとして参加、同年グラフィックの手伝いを経て、秘密裏に『ドラゴンスピリット』にサウンドを載せて1987年正社員登用。花博(1990年:国際花と緑の博覧会)に出展した『ギャラクシアン3』、『リッジレーサー』、『スピードレーサー』等を担当。1996年退職後も「リッジレーサー」、「鉄拳」シリーズ等や他に参加。現在は作家としても活動中。

川田 宏行

1984年、ナムコ(当時)に入社。 開発企画課での『スターラスター』、『ワルキューレの冒険』開発を経てサウンド部門へ。『妖怪道中記』、『ワルキューレの伝説』、『ソルバルウ』、『ナムコ・ワンダーエッグ』、『パックマンCE 2』、『プラ・ソニック・ラブ!』、『大乱闘スマッシュブラザーズ for Nintendo 3DS / Wii U』など多くのサウンドを担当。現在は、作編曲家としてオリジナルCD制作の他、『大乱闘スマッシュブラザーズ SPECIAL』、『アリス・ギア・アイギス』など、幅広く活動中。

中西 哲一

1996年、ナムコ(当時)に入社。代表作は「リッジレーサー」シリーズ、「エースコンバット」シリーズ、『サマーレッスン』など。クリエイターとプログラマの橋渡しを得意とし、サウンドディレクター/テクニカルサウンドデザイナーとして多くのタイトル開発に携わる。現在はバンダイナムコスタジオにて所属グループマネジメントやオーディオ技術開発リーダーを担当。

黒畑 喜弘

小さい頃からのナムコ好きが高じ、1998年にナムコ(当時)に入社。『リッジレーサー7』のサウンド実装を機に社内サウンドフレームワーク「NUSound」の開発に携わり、「KORG Gadget」用シンセサイザープラグイン「Kamata」では過去の社内資料を基にC30音源を再構築。代表作は『太鼓の達人』の「スーハー2000」(ボーカル)。

大久保 博

1994年、ナムコ(当時)に入社。代表作は「リッジレーサー」シリーズ、「エースコンバット」シリーズ、「鉄拳」シリーズなど。バンダイナムコスタジオサウンドチームを経て、現在はバンダイナムコ研究所に所属し、XR、AI技術のビジネスプロデュースや新技術「ELMIRAIVE™AX(旧称:BanaDIVE™AX)」の開発等に携わる。

FM音源時代はクリエイターとプログラマー、エンジニアのコミュニケーションで音源が使いこなされていた

――FM音源IC、YM2151(OPM:ステレオ8ch出力可能)の採用の経緯は前編でお伺いできましたが、サウンドクリエイターの皆さまはFM音源に関して何かエピソードなどありますか?

細江:「システム86」から「システムI」になる時に、FIFO(※1)のバッファ(RAM)が載ったじゃないですか。YM2151に対して、書き込みっぱなしで……。あれはわざわざ付けるに至ったのはどうしてなのかなと。

※1 FIFO:First-In First Outの略。ここではサウンドCPUとYM2151との間をつなぐバッファメモリのことを指す。具体的にはサウンドCPUの処理により、YM2151の制御命令を高速にバッファメモリに書き込み、YM2151の処理待ちに従ってデータを転送する。YM2151は高機能だが命令処理に時間がかかることから、CPUの待ち時間も多くなったため、その待ち時間を減らすために設けられた。

小川:そのころはサウンドと別の仕事を一緒にやっていたのかな。要は(YM2151に)長く待たされると(サウンドCPUが)ほかの仕事ができないから、それを付けたんだと思うんですけれど。

細江:「システム86」の時はFM音源のレジスタを一斉に書き換えると、途中で待たされてノイズが出るんですよ。逆にそれを使っている曲とかもあって。『サンダーセプター』とかで「ザー」とか「ジャン」っていうんですけれども、それは「システムI」じゃもうできなくて。

川田:勝手に直ってる(笑)。

小川:すごい。そんなところまで使っているんだ。

大久保:FIFOがつくことで何が変わったんですか?

細江:サウンドで使っているMC6809が待たされなくて、ずっと走り続けられるので、待たないためには無理やり書かなきゃいけなくて、半分だけレジスタ書いたとか、そうなっていたんですかね。

でも、当時FIFOに関してナムコ(当時)以外は1社たりとも採用していなかった記憶があります。「システム86」から「システム87」(※2)になって、サウンドクリエイター側から見て“あえて載せた有能で地味なチップ”でした。そして無くても動かない訳ではないのはわりと鼻高々ポイントだったかと。

※2 「システム87」:「システム86」の次のシステム基板として『妖怪道中記』や『ドラゴンスピリット』のリリース時は「システム86」から連なる「システム87」という名称になっていた。「システムII」がリリースされた際に「システムI」と名称変更された。

小川:結局CPUを効率的に使えば、ICの個数を減らせたり安くできる、そんな話ですね。FIFOをつけても、その値段分の効果がたぶんあったということなんでしょうね。貧乏性なので、いかにハードウェアを安く作るかというのが命題だったんですね。

黒畑:コスト意識が強かったと。

小川:もちろん。例えば、チップ抵抗で1つに4つが入ったものがあるんですね。まとまったやつ。あれを実装するよりも、別々のものを4つ載せたほうが安いんです。しかも壊れにくいから。今の仕事がリペア(修理)をやっているのでそういう話になるのですが……。(※3)

※3 :小川さんはバンダイナムコテクニカで製品の修理やサポートの業務を担当しています。

黒畑:逆に部品点数が少ないほうが安いのかと思っていました。

小川:実際に調べると、みんな共通部品で作った方が……ババババって実装機で打っているので安く済むと。

新規の音源を扱うためにはエンジニア、プログラマー、クリエイターの協力が不可欠だった

大久保:歴史を順にたどっていくと、FM音源が最初に載った時って、KEY OFF(※4)がないみたいな話があって。新しい音源を載せるのに苦労があったのかな、というのはちょっと知りたいなと思っていたんですけれども。

※4 KEY OFF:鍵盤楽器でいうところの鍵盤から指を離した状態。エンベロープ設定により音量が減衰していく。

小川:ああ、それはドライバの役割だ。ハードはすぐに作れたんですけれども、使う方はけっこう大変だったと思うんです。ドライバを書いていたプログラマーも、試行錯誤して作っていたので、KEY ONしかないプログラムだったということみたいです。

黒畑:プログラムだけの問題だったと。それを知ってから『スカイキッドDX』を聞くと「ゴーン! ドコドーン!」って。

大久保:そうそう。あれもひとつの味なのかな? と。「リリースを使った音楽の作り方」みたいな。

川田:結果、そうなることが多いですよね。KEY OFFができなかったからこそできた、みたいな。

黒畑:『イシターの復活(THE RETURN OF ISHTAR)』とか。

川田:最初、『妖怪道中記』で「システムI」に触った時にびっくりしたんですよ。インテンポなタイミングでしかKEY OFFできない。すぐに自由に時間を指定してKEY OFFできる仕様(GATE TIMEコマンド)を作ってもらいましたけど。

あとは、YM2151のキー・レートスケーリング(※5)とか、レベルスケーリング(※6)のパラメータを全部無効にしてしまっていて、読んでいなかったので(笑)、それを読まないとどういう音になるかというと、どの音もギラギラしたサウンドになるんですよ。だから、「システムI」以前の音って派手目な傾向があったかと思うんですけれども、それを「なんとかしてよ」って(プログラマーに)頼んだんですけれど、「パラメータが入りきらない」と言われてしまって。

※5 キー・レートスケーリング:音域によってエンベロープ・ジェネレーターの速度をコントロールする。

※6 レベルスケーリング:音域によってオペレーターのレベルを調節する。

小川:それはプログラマーの言い訳じゃないですかね(一同笑)。多分、プログラムの構想が頭にあって、大きく変更が必要だったんでしょうね。

川田:そうなんですかね(笑)。仕方がないので高い音域用にちょっと音色を丸めたものを用意して、演奏(シーケンスデータ)中に切り替えて対応するしかないな、と思ったことを覚えています。

大久保:『妖怪道中記』の時はそういう状態で作られたんですか?

川田:キー・レベルスケーリングとかは音色のほうで対応しました。

大久保:あれであそこまで仕上げたんですね。

川田:だからこそ、ナムコ(当時)のFM音源ならではのインパクトが出せたという考え方もあるんですよね。

細江:「システムII」の時ってその辺の仕様って変えられました?

川田:「システムII」でのFM音源のドライバ仕様に変更はなかったんじゃないかな?

細江:「システムI」のデータを「システムII」にもっていったら違う音になってしまって(※7)、何かの計算を変えたっていう話をちらっと聞いたんですけれど。記憶があまりなくて。

川田:それは知らないかも。

※7:「システムI」でリリースされた『ドラゴンスピリット』の続編『ドラゴンセイバー』は「システムII」でリリース。裏技でBGMを『ドラゴンスピリット』バージョンに変更できた。

大久保:例えば『イシターの復活』とか『スカイキッドDX』とか、『源平討魔伝』の時のFM音源で鳴っているというものと、『ワンダーモモ』ぐらいまではリリースが「ボーン」って鳴っているイメージがあって。『ドラゴンスピリット』や『妖怪道中記』からすごいきれいになったイメージが僕らにはあるんですけれども。直ったタイミングはいつなんだろう?

川田:たしか「システムI」からだと思う。

細江:「システムI」のドライバは休符コードがありましたよね。

川田:「システムI」のドライバには休符コードがあって、インテンポでゲートタイムを切る、KEY OFFを指定することができるようになっていたんですよ。

大久保:ハードは変わっていないけれどソフト(ドライバ)だけ変わったと。

川田:そうです。あと積極的に音色もエディットするようになったので、サウンドも変わっていったんだと思いますね。

クリエイター側が使いこなして機能活用を逆提案したFM音源

大久保:FM音源ってパラメータと鳴る音の仕組みが普通の人にはわかりにくいじゃないですか。サウンドチーム内であれだけ整った音になったのがすごいな、というか、音色作りから皆さんすごく作りこまれていたのかなと。

川田:自分の場合は、自分でDX7(※8)とか買い込んで、その日からひたすら触りに触って「こういう音はどうやったら出るんだろう」みたいなことを試して。当時、YAMAHAもDX7を売り込むキャンペーンをやっていて、インストラクターさんと「この音どうやったら出るんでしょうね?」みたいなことを話していたぐらいのめりこんでいたので、FM音源に関して自分は抵抗がなかったんですよね。めがてん(細江さんの愛称)の場合ってどうだったんですか?

※8 DX7:YAMAHAの6オペレータ16音同時発音のFM音源シンセサイザー。1983年発売。

細江:最初使ったのが会社にあった「カシオトーン(※9)」や「ポータサウンド(※10)」だったので、自分ではシンセは持っていましたが、そこまで理解はできていなかったですね。

※9 カシオトーン:カシオから発売されていた電子楽器。初代は1980年発売。29種の固定音色だった。

※10 ポータサウンド:YAMAHAから発売されていた電子楽器。初代は1980年発売。音色固定で最大8音発声可能。

川田:シンセサイザーは触っていたから基本的な考え方で音色とかも(エディット)できてたんだよね。

小川:DX21(※11)で作った音色パラメータを参考にしたって聞いたんだけれど。

※11 DX21:YAMAHAから発売されていたFM音源(4オペレーター)搭載のシンセサイザー。

川田:なんですけれども、そのままだとレートスケーリングだとかレベルスケーリングに対応していなかったのですごい音になって……(笑)。でもすごく重宝しました。

――細江さんはFM音源にはどう慣れていったんですか?

細江:DX7はちょっと複雑すぎたので、4オペレーターのYM2151とか2オペレーター(※12)のものを触っているうちに慣れてきたという感じですね。

※12 2オペレーター:FM音源におけるFM合成機の数。2オペレーターのFM音源としてはYM2413(OPLL)などがある。

――当時FM音源を理解できなかった側として「慣れる」っていう感覚がイマイチしっくりこないんですけれど(笑)。

細江:音楽の理論が書かれている本を参考にしました。この音は奇数倍音が鳴るのかどうかとか、楽器の構造があって、ギターみたいに両端が抑えられているものの真ん中を揺らすと偶数倍音がなくなるとか、何倍音を重ねていくとこんな感じになりますという感じで役に立ちました。構造が複雑になるとわからなくなってしまうので、まずは2オペぐらいがいいかな……。そこからもうちょっと必要になった時に上に(オペレーターを)載せていくという感じで理解していきました。

川田:より変えたい時に(モジュレーターやオペレーターを)積んでいくみたいな。

小川:やっぱり(実際に)やっていくうちにいろいろわかっていくんだね。

細江:そうですね。あとはずっとダンプリストを見ながらパラメータを変えていって鳴らして……。

川田:気が遠くなる(笑)。

細江:でも昔は方法がなくて、それしかできなかったですね。

「ナムコフォーマット」はあくまでインタラクティブなゲームに向けて作られ継承されていったもの

――そのころのハードウェア設計とクリエイターのあいだに立って下支えをしていたドライバに関してはどうなっていたんでしょうか? 第1章でも触れていただいた「ナムコフォーマット」が8chに対応した記述方式に変わって継承されていったと伺っているのですが……。

小川:8音に対応したのはFM音源からだよね。あれの基礎を作ったのは水足君(※13)で、彼が作ったものからずっと引き継がれていると思います。

※13 水足淳一:ファミリーコンピュータ版『源平討魔伝』やアーケード版『バラデューク』でC30による音声合成などを担当。

――気になっていたのは、C30以前よりドライバプログラムが独立してハードウェアに合わせてドライバが記述されていたと思うのですが、いわゆる「ナムコフォーマット」も含め、姿を変えつつもゲームに向いたサウンドシステムとしてのコンセプトに、FM音源からPCM音源へとテクノロジーが進化していっても通底したものを感じると思うのですが……?

細江:偶然じゃないかな(一同笑)。ドライバの書き込みの形式はHP64000という入力装置があって、そのエディタで打ちやすいようになっていた気がします。ほかのそれまでのPCのスクリーンの状態ではなくて、HP64000で書きやすいのがあのフォーマットだったんじゃないかと。

小川:横に8音分並ぶといっぱい、みたいな。

細江:データバイトの並びの構造みたいな。DB文がずっと並んでいるっていう。

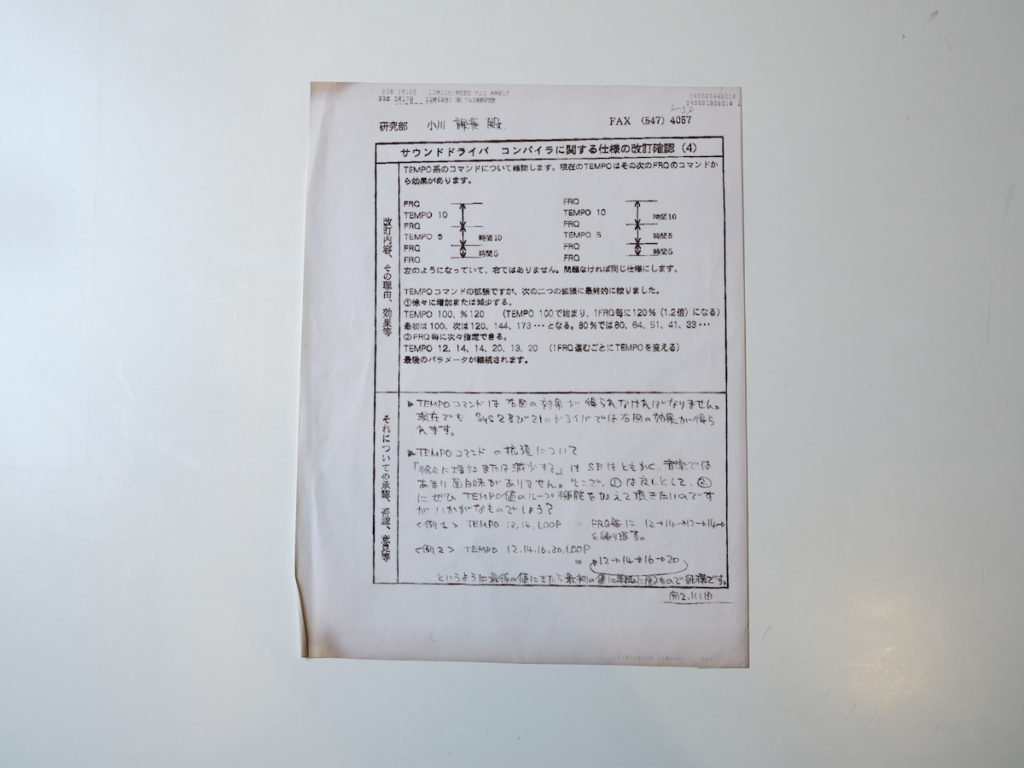

小川:私も「クワトロ」というドライバを書いたことがあって、その時にはクリエイターの方たちにどのようにしたらいいか、アンケートを取りました。ここにそれがあるんですけれど。どんな仕様にしたらいいかお伺いを立てて。コマンドの重要度の高い、低いといったことも教えてもらって作ったんです。

小川:(PCM時代になると)24ch出るのに横に8つ(演奏データが)並ぶ形式を踏襲したのはどうしてなの? という疑問もあると思うんですけれども、そのぐらいが扱いやすいというか。当時はたしかPC-9801に「MIFES」(テキストエディタ)かなんかでカット&ペーストでどんどん(演奏情報や音色データを)増やして書いて作っていた時代だったと思うんですが、クリエイターさんの意見を聞いて同意を得られたので、横に8音のデータが並ぶという方式を踏襲しようということになりました。

川田:後々確認を取っていないんですが、水足さんは楽器とかも詳しい方で、「なんでこの書式になったんですか?」って聞いたんですよ。そうしたら「MemoryMoogのシーケンサーの表示を参考にしたんだよ」って。MemoryMoogは触ったことがありますが、シーケンサーは触ったことがないので……。

小川:僕もそう聞いたよ。

細江:シーケンサーは載ってましたっけ?

川田:触ろうと思ったことはなかった。確証を取ってはいないのですが、ひょっとしたらそれが本当にそもそもの始まりだったかもしれないですね。

大久保:そんな話が……。

細江:(そのころのシンセの液晶の形式が)横長になっていたからということですかね。

川田:横長2段のLCDでね。

細江:KORGもそんな感じですよね。でも触らないんですよね。

川田:触りたくないんですよね。

大久保:ヨーロッパで流行っていたTracker(※14)と音の入れ方とか似てますよね。

※14 Tracker:音源モージュールIC等、特定の音源を制御するためのシーケンサーの一種。

大久保:発祥はみんなMoogだったりして。でも音楽を作るツールでありながら、縦軸の時間処理とかがとてもプログラム的な考え方から来てるんだよなと思ったんですよね。

VSYNCの割り込み処理の関係で、1/60秒(1インター)をベースにして、それを整数倍したタイミングで縦軸が進行されていくというやつ。これで単位音符の長さを決めることで、テンポが決まってたんですよね。音楽的に考えるというよりは、プログラムの都合から来ているあたりがすごく面白いと思っていました。

で、最初は1列(1チャンネル)ずつシーケンスを書いていたじゃないですか。単純に横に時間軸を揃えて見れると理解しやすいので、8ch並べて表示するようになったんだろうなって勝手に思っていました。

黒畑:縦に並ぶやつはアセンブラで書くプログラム的な記述法だなと思っていました。

川田:まさにそのまま。時間軸で横に並んでいると和音がわかりやすいので、それはとても助かりましたね。

細江:MMLのような書式と違ってチャンネル毎の時間軸がバラバラにならないのは、すごくありがたかった。

黒畑:(基板に)FM音源とC30が両方載っていた時(システム86など)って、両方別々に?

川田:別々のデータ形式で入力していました。

黒畑:どちらかのデータ形式に統一されているのかと思ったら……。

細江:違うドライバで動いてた。

黒畑:以前解析したときに、違うデータの置き方で違うドライバで動いていたのには気付いていたんですが、コンバーターでもあったのかと思ったら、本当に別々だったんですね……。

大久保:元々楽器を触っていた細江さんや川田さんは入社して初めてあのシーケンスデータ書式を見て、すぐ慣れたんですか?

細江:当時カモンミュージックの「レコンポーザー(※15)」とかもあの書き方……8つは並んでいなかったのですけれども、あんまり抵抗はなかった。

※15 レコンポーザー:カモンミュージックが発売したパソコン用MIDIシーケンサー。演奏データを記録するのではなく、数値を打ち込んで演奏データを作るステップ入力方式を採用していたことで「楽器を弾けなくても音楽が作れるという点が大きな特徴だった。

川田:「なんか曲作って!」と言われたら勉強するしかないものですよ。

大久保:僕がちょっと聞きたいのは、「ナムコフォーマット」の書き方を見て、ゲーム向けに特化したインタラクションに対しての機能がむちゃくちゃあるな、すごいなと感動したんですけれども。おふたりはあの書式で作って、インタラクティブなゲームのサウンドが出るというところに「なるほどね」という感動みたいなものはありましたか? 当時はC30とかの話かもしれないですけれど。

川田:MIDIシーケンサーでできないことができてステキでしたね。例えば(BGMや効果音を)ループさせておいて、CPUからフラグが立つと次(の曲)へ飛んでいくとか。インタラクティビティを発揮できるようなシーケンスデータが作れるので、「ゲーム開発会社ならではだな」と思いました。

ハードは大道具や小道具、どう使うかはクリエイター次第

小川:ひとついいですか? サウンド関係の社内の方がいらっしゃるので、自分のノウハウを伝えておきたいと思っているんですけれど。ナムコPCM音源と「クワトロ」の限界について。

この組み合わせではフロント2ch、リア2chまで出力できますが、作った当時はこの組み合わせなら音量を360度振れば(出音に)方向性が出るだろうと思っていたんです。でも、あとで実験して分かったのですが、音の方向性というのは音量だけでは人が知覚できない。位相というか、“音が右の耳と左の耳に到達する時間差”でわかるんです。

まず2chで実験したんですが、サウンドのドライバで1インタラプト(この場合1/120秒)ずらして発音すると、それだけでは全然方向性が感じられず、エコーやリバーブがかかったように聞こえてしまう。1/120秒遅らせるというのはどのぐらいかというと、音速が340m/秒とすると3m~4m遅れることになる。それではもう1つの音に聞こえない。(音源と)右の耳と左の耳の差というのは数cmのレベルでしかないので。

そこで波形アドレスのスタート位置を変えてみました。これなら左右の音のずれをcm単位で変えられる。同じ波形を右と左のスピーカーからcm単位でずらして出せば見事に定位するんです。到達時間のほうが、位相の変化というのが人間の耳には大事だとわかりました。

これは鋭い立ち上がりの音でよく分かり、立ち上がりの鈍い音は方向性がわかりにくい。だからバーチャル音源のデモにヘリコプターの音などを使うのですけれども、あの音はローターの回転の立ち上がりの「パラパラパラ……」という音が連続しているので、変化がすごくわかりやすい。

では、実際にナムコPCM音源とクワトロにそこまでの機能がつけられるかという話ですけれど、難しいですね。バーチャル音源に近いゲーム性だと、やっぱり場所がリニアに移動していかないとゲームの世界で使えないと思います。それをやるためには数cmの違いで出た音をCPUからの指示でまた元に戻してゼロになったり逆になったりということをやらなきゃいけないんですけれど、それは大変な作業になる。

結局、ある波形の音がその片方が早かったものがもう一方では遅くなるというのは、周波数変換が起きているんですね。いわゆるドップラー効果(音源と聴く人の距離が変化する時に音の高さが変わって聞こえる現象)のような、そのとてもやわらかいものが左右のchで起きている。この時代の音源には、まずそれを思いついたとしてもたぶん載せられなかった。DSP(Digital Signal Processor:特定の演算処理を高速に行うことを目的に作られた演算器)などで処理する世界だと思います。なので、今後音源を触る方には、「音の到達時間、位相ってすごく大事だよ」ということをお伝えしたいです。

黒畑:今の技術でも、最初からハードウェアを含めていろいろ考えて設計しないとなかなか難しいですね。プログラムやドライバだけでなんとか……というわけにはいかないレベルです。

中西:そのレベルにいくには、(このインタビューの)PlayStation3の話までお待ちください(一同笑)。

細江:エフェクトとして使うには、それって波形のアドレスの位置を変えてフランジャー(※16)っぽく聴かせるというのには使えますね。8本使って広がりをもたせるというのは8本分全部計算して何秒後にその波形に到達するみたいな形で並べておいて、ふわっと(プレイヤーの周りを音が)回るみたいなことはできますね。

※16 フランジャー:短時間の時間遅れを連続的に変化させて元の音と混合することでジェット音のようなモジュレーション効果を起こすエフェクター。ギターなどに使われる。

小川:なるほど。ハードって演劇でいう大道具、小道具の世界なんですよ。それをどう使ってくれるかというのはクリエイターの技量で、ハード設計側からは想像できないような音や音楽が出てきますので、ハード設計者としては「すごいな~」と感心するばかりです。

「やりたがり」が「やりたいことをやる」Willマインドの実現

川田:そもそも私もめがてん(細江さんの愛称)もサウンドの人間として入社したわけではないんですが、サウンド仕事は溢れていたんですよね。「やってみたい!」と話せばすぐにいろいろと教えてもらえました。ちゃんとレジュメみたいなものを作ってきていただいたりして。

細江:僕が入社したころって、僕と川田さんと中潟さんと小沢さんの4人がサウンド担当だったんですが、作業場所が全員バラバラだったんです。

川田:そうそう。一緒(の場所で仕事をしていた)ってことがあんまりなかったよね。昔は。

細江:ほぼなかった。やっとサウンド部屋っていうのができて初めて一緒になった。

川田:(それ以外は)ゲーム制作陣の近くにいたという。

細江:プログラマーの横での仕事がほとんどでした。だからあまりお互いに深い接触はなかったですね。それから、僕は勝手にサウンドをやっていたので、「細江には教えるな」って(通達が)出ていたらしいので(一同爆笑)。

川田:それは聞いたことがないけれど(笑)。私も企画の部署にいたんですが、タイトル開発後にそのゲームのプロモーションビデオを作るという業務があって。その音楽や効果音を自前の楽器を会社に持ち込んだりして作っていたら、サウンドが仕事になったみたいな感じ。

大久保:それはサウンドとして誘われたということじゃなくて、企画をやりつつ、開発が始まったら作っちゃえって感じですか?

川田:そうです。企画にいたころから担当していたタイトルのサウンド制作もしていたので。

小川:ひょっとしてそれは「Will」の精神ですか? (※17)

※17 Willの精神:ナムコ創業者である中村雅哉氏の「知っているより好きであるほうが、好きよりも楽しいほうが、よりいい仕事ができる」=「知・好・楽」の考えを実践的に説明したもの。受動的に「これをしなければならない」(Must)で考えるのではなく、「今日はこれをしよう」(Will)と主体的な考えを起点に仕事の楽しさやおもしろさが生まれるという考え方。

川田:それが大きいですね。

中西:それ、すべてにおいて全部繋がっているかも。上から「やって」と言われたことはともかく、自分はこっちの方がいいと思ったので「やってみちゃいました!」過去形です(笑)。

黒畑:やっていたことをあとから上の人に追認してもらって、勝手にやっているけどまあまあよしとしよう、ぐらいな感じで。

小川:なんという会社だ(笑)。

川田:それはけっこう「ナムコイズム」の真髄をついているかもしれないですね(笑)。

中西:そこは大事なところかもしれないです。そこは目をつぶってくれるとか、許容されるところがあったりとか。

小川:よくとればね(笑)。

大久保:最後は「Willマインド」でまとめますか。

――それって「サウンド開発」は「サウンド担当がいないから自分がやっちゃえ」みたいな感じなんですか? サウンド担当が開発に入る時期はやっぱり最後になりがちで、サウンドクリエイターが調整することでゲームが仕上がるから、プロジェクト関係者は近い距離にいた方が、効率いいという考えもあったのかもしれませんね。

細江:作業日報を書くうえで、各部門に予算がつくじゃないですか。でも僕らは(自分の担当部署と)全然別のところに行っているので、それは怒られますよね(笑)。

大久保:でも皆さん全員、基本「やりたがり」ってことですよね。

川田:それはそうですね。

中西:それはもちろんやることをやったうえで……(笑)。

小川:うまいなー(笑)。

――それがナムコ(当時)の社風というか、働いていた皆さんが作り出した空気感なんですね。「ナムコイズム」の芯には「自分がやりたいことをやる」があって、それを発揮しやすい空気があり、クリエイターをはじめ皆さんがそれぞれWill精神を発揮された結果だったということですね。ありがとうございます。

バンダイナムコ知新「第8回 第2章ナムコサウンドの発展の足跡を追う【前編】」小川徹氏、細江慎治氏、川田宏行氏、中西哲一氏、黒畑喜弘氏、大久保博氏インタビュー

※バンダイナムコ知新では、当時の資料や関係者への取材をはじめ、皆さまの知見もお借りし、できる限り正確な記事を目指しております。一部事実と異なる場合がございましたら、後日訂正をさせていただきますので、予めご了承いただけますと幸いです。

【※本記事に引用している参考資料につきまして】

・本文中のBGMや効果音などの音源へのリンクは、お客さまのご利用環境によってアクセスできない場合があります。

・動画は、移植版タイトルのものを引用しています。

【補足】タイトル後の年号は稼働開始年を表記しております。

【編集後記】

前編のナムコカスタム音源C140やC352の進化の経緯から、今回はFM音源の導入による変化、ドライバの進化といった、インタラクティブ性を重視したゲームを志向したナムコのサウンドシステムの進化がうかがえるお話でした。

第8回第2章も大久保さんにアドバイザー兼インタビュアーとしてご協力いただきました。また、インタビュイーの皆さまにも内容をご確認いただき、当時の貴重な情報を追加していただきました。

次回はアーケードの隆盛とともに当時急速に拡大していた家庭用ゲームにおけるサウンド開発現場の事情に話を広げてお話を伺っていきます。

取材・文/佐伯 憲司

ライター/編集者。ゲーム関連本、ニュースサイト、攻略映像などに関わったのち、現在フリー。ナムコのゲームとの出会いは、薄暗い中で極彩色の色とド派手なステージスタート音に思わず2度見した『ギャラクシアン』。当時は「ゲームセンター」だけではなく喫茶店や個人商店のはなれなどでもゲーム機と出会うことができました。

1979年、ナムコ(当時)に入社、半年の営業研修後、ビデオゲーム開発部署に配属(当時『パックマン』を試作中)。『ギャラガ』プログラマーを担当後、ハードウエア開発、3Dハード前までの各種ハード、システム基板、カスタムICなどの設計を担当。JAMMA VIDEO規格専門小委員会に参加(副委員長)、通信プロトコル草案の策定にも携わる。PlayStation®︎互換アーケード基板「SYSTEM11」をSCE(ソニー・コンピュータエンタテインメント:当時)と共同開発。量産治具「フラッシュライタ」を製作。その後、役職定年で希望してAMサービス部に転籍。アーケードハードの修理を現在行っている。